Genetec: Was wir heute schon von der Technologie erwarten können

Cloud, Künstliche Intelligenz, Machine Learning, Deep Learning – diese Begriffe haben die meisten schon einmal gehört und glauben zu wissen, was sich dahinter verbirgt

Cloud, Künstliche Intelligenz, Machine Learning, Deep Learning – diese Begriffe haben die meisten schon einmal gehört und glauben zu wissen, was sich dahinter verbirgt. Viele kommen in der Praxis aber schnell ins Schlingern, wenn solche Fachtermini erklärt und voneinander abgegrenzt werden sollen und welche Rolle sie bei der Videoanalyse spielen.

Wo KI draufsteht, ist meist keine echte KI drin

Künstliche Intelligenz (KI) ist ein weit gefasster Begriff, der erstmals 1956 in der Forschung auftauchte. Die meisten Menschen haben Ihre Vorstellung von KI aus der Popkultur. Sie denken an den Roboter, der Emotionen zeigen kann, oder Maschinen, die die Weltherrschaft übernehmen wollen. Aktuelle Beispiele für das, was viele als KI in unserem Leben ansehen sind beispielsweise der Schachcomputer Deep Blue, der einen Top-Schachspieler schlägt, Siri, die jeden Song erkennt, oder Amazon, das Kunden immer ein neues Buch vorschlägt. In Wirklichkeit sind dies aber Beispiele für immer kleiner werdende Computer, die eine Reihe von Algorithmen ausführen, riesige Datenbanken durchsuchen oder viele Berechnungen sehr schnell durchführen.

Der Begriff KI kann dementsprechend unpräzise sein und weckt oftmals unrealistische Erwartungen. Obwohl Künstliche Intelligenz gerne als Marketing-Label genutzt wird, handelt es sich bei den aktuell am Markt für physische Sicherheit verfügbaren Technologien in den meisten Fällen um das sogenannte maschinelle Lernen (Machine Learning).

Machine Learning, Deep Learning, Self-Learning?

Machine Learning ist ein Teilbereich der Künstlichen Intelligenz. Computer werden dabei mit Daten gefüttert, die ihnen dabei helfen, ihre Leistung zu verbessern, ohne explizit programmiert zu werden. Beim statischen Programmieren erhalten Computer eine Reihe von Anweisungen, die sich im Laufe der Zeit nicht ändern. Beim Machine Learning hingegeben können Programmierer einen Computer in die Lage versetzen, seine Berechnungsprozesse durch Training zu bewerten und zu verändern.

Konkret heißt das: Ein Computer wird mit Algorithmen programmiert, mithilfe derer er selbst entscheidet, welche Merkmale er im Erkennungsprozess verwenden sollte, um das genaueste Ergebnis zu liefern. Vereinfacht ausgedrückt: Der Mensch bringt dem Computer bei, selbst zu erkennen, anhand welcher Kriterien er bestimmte Ereignisse, Prozesse oder Objekte klassifiziert.

Eine Form des Machine Learnings ist das sogenannte Deep Learning. Sie benötigt große Datenmengen, ist dafür aber in der Lage, ähnlich wie das menschliche Gehirn, Prognosen und Entscheidungen zu treffen und diese immer wieder mit neuen Daten abzugleichen und anzupassen. Typischerweise werden mit Deep Learning komplexere Modelle trainiert. Deep Learning kommt beispielsweise bei der Gesichtserkennung zum Einsatz.

Erfolgt ein andauernder, nicht aktiv überwachter Lernprozess durch das System, spricht man von Self-Learning. Diese Technologie existiert heute bislang nur in Ansätzen und ist aufgrund auch unerwünschter Ergebnisse und Entscheidungen umstritten.

Videoanalyse – alles vollautomatisch?

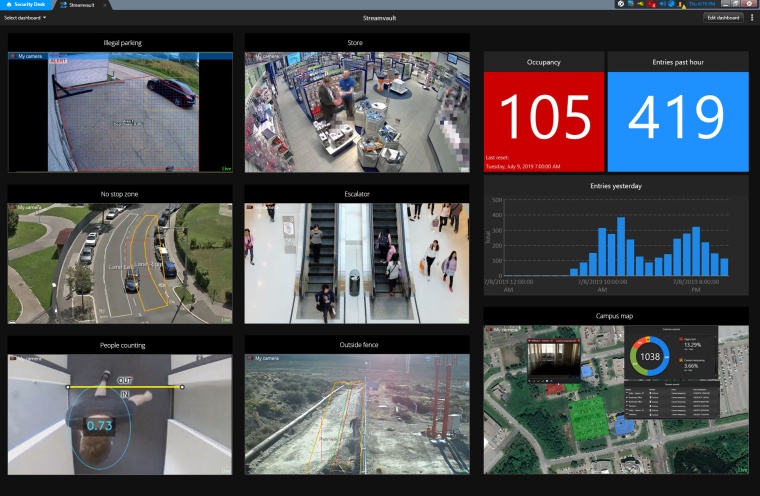

Ebenso verhält es sich beim Thema Videoanalyse. Bei der Entscheidung für eine Lösung, sollten Anwender genau überlegen, was sie tatsächlich benötigen. Wer viel „Intelligenz“ will, zahlt schnell horrende Summen für die entsprechende Computerpower und Speicherkapazität, braucht für die spezifische Anwendung aber vielleicht gar nicht diesen Intelligenzgrad. Entscheidend ist also weniger die Intelligenz als vielmehr der gewünschte Automatisierungsgrad. Das Spektrum reicht von automatischer Erkennung, Bewertung und Analyse, bis hin zu automatisierter Entscheidungsunterstützung und automatisiertem Lernen. Daraus lässt sich eine Kernfrage ableiten: Wo soll der Schwerpunkt liegen?

Beim Thema Videoanalyse geht es vorrangig darum, Veränderungen und Muster zu erkennen. Das System arbeitet dabei entweder statisch, dynamisch oder anwendungsspezifisch. Je nach Intelligenz des Systems werden also lediglich Veränderungen in einem Bild aufgezeigt oder es werden Muster bzw. bestimmte Dinge „erkannt“. Dies geschieht durch Algorithmen, die in einzelnen Pixeln ein Muster erkennen und das Ergebnis entsprechend interpretieren.

Statische, dynamische oder anwendungsspezifische Videoanalyse

Bei der statischen Videoanalyse lernt das System ein Standardbild, auf dem es dann jede Veränderung erkennt, was anschließend eine vordefinierte Aktion (z B. Alarm oder Speicherung der Aufnahme) auslöst. Um einem Fehlalarm vorzubeugen, werden zusätzliche Algorithmen als Filter eingesetzt, die z. B. erst ab einem bestimmten Ausmaß der Veränderung einen Prozess auslösen.

Die dynamische Videoanalyse dient vor allem der Erkennung sich bewegender Objekte. Neben der Anwesenheit eines Objekts oder Menschen, wird zusätzlich auch beispielsweise die Anzahl, Bewegungsrichtung und ggf. Geschwindigkeit erkannt. Eingesetzt wird diese Methode unter anderem bei Autos im Verkehrsfluss (z. B. um Falschabbieger zu erkennen), Personengruppen (z. B. zur Erkennung von Helm- oder Maskenträgern) sowie im Perimeterschutz.

Im Rahmen der anwendungsspezifischen Videoanalyse kommen spezielle, für die jeweilige Aufgabe optimierte Algorithmen zum Einsatz. Einen Algorithmus, der alles kann, gibt es nicht. Es gibt jedoch bereits Ansätze, dass das System erkennt, welcher Algorithmus das beste, bzw. ein sinnvolles Ergebnis erzeugt. Anwendungsspezifische Videoanalyse kommt besonders bei der Personen- und Objektidentifikation oder bei der Analyse von Bewegungsmustern zum Einsatz.

Das Einsatzgebiet: Echtzeit oder Analyse gespeicherter Daten

Bei der Analyse unterscheidet man darüber hinaus eine Echtzeitanalyse und die Analyse „historischer“, also aufgezeichneter Daten. Werden Daten aus Videoanalyse-Systemen in Echtzeit genutzt, geht es vor allem um das sofortige Erkennen und die sofortige Reaktion. Diese muss angemessen und unmittelbar erfolgen. Wichtige Aspekte sind dabei Schnelligkeit und die Entlastung des Sicherheitspersonals. In kritischen Situationen sollen die Systeme anhand geeigneter Algorithmen Fehlalarme vermeiden und durch eine Kombination aus Alarmen und Aktionen die richtige Vorgehensweise unterstützen bzw. weitestgehend automatisieren. Dazu gehört auch, dass die Lösung in der Lage ist, Ereignisse in einem dynamischen Umfeld vorherzusagen und/oder operative Daten in die Analyse einzubeziehen (z. B. Wetter, Uhrzeit, zugelassene Personenzahl oder besonders kritische Objekte). All das muss der Software beigebracht werden und erfordert im laufenden Betrieb hohe Rechenleistung und Speicherkapazität. Teilweise sind solche Rechenoperationen bzw. Funktionalitäten bereits in Überwachungskameras integriert. Aber Vorsicht: Diese sind meist auf eine bestimmte Aufgabe fokussiert (Perimeterschutz ist nicht Brandschutz).

Kommt Videoanalyse vor allem nachträglich bei Aufzeichnungen zum Einsatz, sprechen wir von forensischer Suche. Dabei geht es vorwiegend um forensische Analysen bei Vorfällen sowie Auswertungen, um weitere Erkenntnisse zu gewinnen, z. B. Muster zu erkennen und daraus die richtigen Schlüsse zu ziehen. Ein Anwendungsbeispiel ist die Analyse von Verkehrs- oder auch Kundenströmen. Hier werden intelligente Algorithmen und Lernsysteme eingesetzt, die Korrelationen bei Daten aus unterschiedlichen Quellen erkennen. Der Fokus liegt hierbei also auf der Verarbeitung großer und komplexer Datenmengen. Diese Aufgabe erledigen Rechner mit entsprechender Rechenkapazität besser als eine mit KI-Technologie ausgestattete Kamera.

Fazit: Nicht alles, was möglich ist, macht Sinn

Videoanalyse kann heute bereits sehr viel. Wer sich für den Einsatz eines solchen Systems entscheidet, sollte sich allerdings genau überlegen, welche Lösung für seine individuellen Anforderungen die richtige ist und vor allem die Wirtschaftlichkeit von Anfang an im Auge behalten. Dabei gilt die Faustregel: Je intelligenter ein System sein soll desto teurer wird es. Sollen mehr Daten verarbeitet werden, ist mehr Rechenkapazität notwendig und eine intelligente, datenintensive Echtzeitanalyse treibt den Preis schnell in die Höhe. Nicht immer ist das für den täglichen Betrieb aber notwendig. Egal, für welche Lösung man sich entscheidet, sie muss vor allem wirtschaftlich gerechtfertigt sein. Je nach individuellem Anforderungsprofil kann es dann auch sinnvoll sein, über eine zentrale Sicherheitsplattform nachzudenken, die einen flexiblen, herstellerunabhängigen Einsatz von Endgeräten und Hardware ermöglicht.

Business Partner

Genetec Deutschland GmbHDe-Saint-Exupéry-Straße 10

60549 Frankfurt

Deutschland

Meist gelesen

GIT SICHERHEIT AWARD 2026 – Die Gewinner stehen fest!

GIT SICHERHEIT AWARD 2026: Die besten Sicherheitslösungen des Jahres – jetzt alle Gewinner im Überblick

Airbus Defence and Space: Sicherheit als strategischer Pfeiler für Europas Verteidigungsfähigkeit

Airbus Defence and Space schützt mit modernen Sicherheits- und Cyberlösungen Standorte, Technologien und Mitarbeitende – und stärkt so Europas Resilienz in unsicheren Zeiten

Sicherheit für die Deutsche Bahn – Interview mit Britta Zur

Britta Zur hat zum 31. Oktober 2025 den Vorsitz der Geschäftsführung bei DB Sicherheit niedergelegt. Das Interview führte GIT SICHERHEIT im Frühjahr 2025.

Sicherheit im Ernstfall: Wie Unternehmen mit strategischem Personenschutz und Amokprävention Verantwortung übernehmen

Personenschutz & Amokprävention: Strategische Konzepte, Training & Verantwortung für Unternehmenssicherheit

Museumsicherheit: Wie moderne Technologien und ganzheitliche Schutzkonzepte Kulturgüter vor neuen Bedrohungen schützen

Museen im Spannungsfeld: Sicherheit zwischen öffentlichem Auftrag, Raubfällen und neuen Bedrohungen